Hace tiempo hablé acerca de la importancia de controlar las principales métricas de desempeño de los clústers de Databricks. Sobre todo, si quieres habilitar una estrategia FinOps con el propósito de optimizar tus procesos de analítica avanzada en la nube. Pues en esa ocasión, hablé acerca la librería Overwatch. Se trata de una librería que se instala en cada clúster y que tras habilitar Diagnostic Settings en el proceso de configuración del Databricks Workspace y seleccionando el modelo de envío como stream a Event Hub, recuperabas infinidad de información detallada sobre el comportamiento de tus máquinas y recursos.

Si quieres ampliar la información acerca de Overwatch, pulsa aquí

Obviamente, eso era el pasado ya que, hoy en día, prácticamente nadie trabaja con Databricks sin incluir Unity Catalog. Unity es la capa de Gobierno de Datos que provee Databricks como solución a la gestión de los permisos de acceso a los recursos de los diferentes usuarios (y grupos). Pero también provee de un Catálogo de Datos e incluso habilita la posibilidad de identificar el linaje de los datos entre las distintas capas que conforman, por ejemplo, una arquitectura de medallas. Hasta aquí, casi seguro que nada nuevo bajo el sol para la gran mayoría, ¿verdad?. ¡Pues ahora viene la guinda!

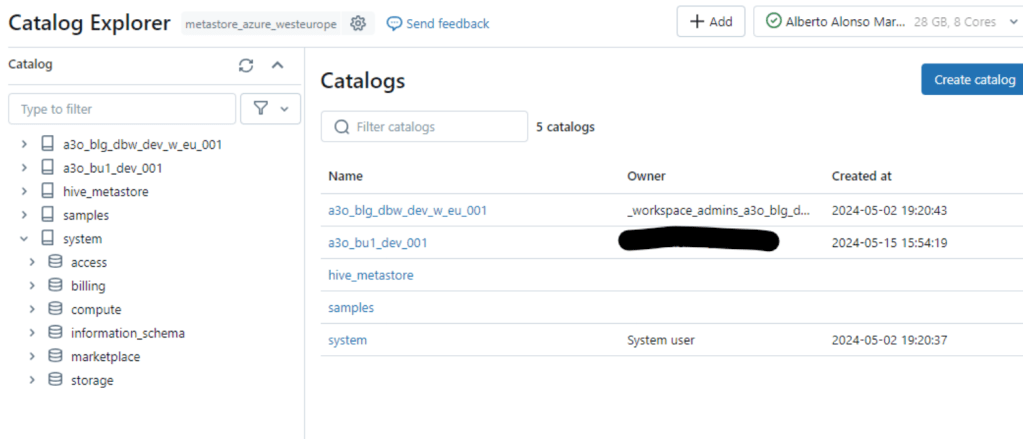

En Unity Catalog existe una serie de schemas que recogen el detalle de los procesos que se ejecutan dentro del ecosistema de Databricks, y para muestra un botón. Abajo puedes observar los schemas que cuelgan del Catalog llamado system una vez habilitados. Estos schemas «chivatos» son: access, billing, compute, marketplace y storage y te permiten acceder a infinidad de datos con los que construir métricas a incluir en tus propios dashboards. Si miras dentro de tu Catalog Explorer verás que el schema information_schema, es el único que está habilitado por defecto.

Como decía un poco más arriba, con ellos, dispones de la posibilidad de componer tus propios dashboards y así poder realizar un seguimiento más detallado de tus componentes, performance, costes.

Aprovecho yoOs muestro una de las pestañas que puedes desplegar rápidamente desde el tutorial de Databricks donde se monitoriza el consumo de mi recién desplegado Databricks Workspace. Como siempre, los de la «pasta» primero 😉

Para terminar, aquí os dejo el enlace al tutorial de Databricks

Cada vez es más necesario disponer de una estrategia de control de costes que te ayude a optimizar procesos y soluciones para evitar que los responsables pongan el grito en el cielo al aterrizar facturas elevadas. Por otro lado, estas buenas prácticas enriquecen tu perfil y te ayudan a extender tu conocimiento sobre soluciones como Databricks.

Espero que te haya resultado interesante y puedas emplearlo para reducir la cuenta y ofrecer ventajas a las organizaciones con las que colabores.

Foto de portada gracias a cottonbro studio: https://www.pexels.com/es-es/foto/escaleras-misterioso-retro-bw-7319069/